IA

Los Chat Bots están inventando respuestas

Se están verificando acciones donde los nuevos dispositivos generan texto no basadas en datos sino en conjunciones creadas producto del aprendizaje automático. Nota el el Times

Cuando la start-up de San Francisco OpenAI presentó su chatbot en línea ChatGPT a fines del año pasado, millones fueron cautivados por la forma humana en que respondió preguntas, escribió poesía y discutió casi cualquier tema. Pero la mayoría de la gente tardó en darse cuenta de que este nuevo tipo de chatbot a menudo inventa cosas.

Cuando Google introdujo un chatbot similar varias semanas después, lo hizo arrojó tonterías sobre el telescopio James Webb. Al día siguiente, el nuevo chatbot de Bing de Microsoft ofreció todo tipo de información falsa sobre la Brecha, la vida nocturna mexicana y la cantante Billie Eilish. Luego, en marzo, ChatGPT citó media docena de casos judiciales falsos mientras escribía un informe legal de 10 páginas que un abogado presentó a un juez federal en Manhattan.

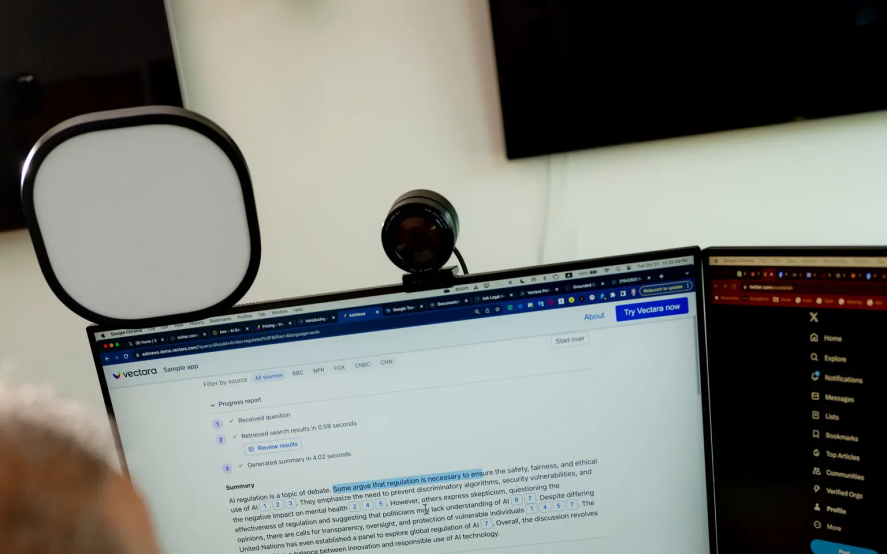

Ahora, una nueva empresa llamada Vectara, fundada por ex empleados de Google, está tratando de descubrir con qué frecuencia los chatbots se desvían de la verdad. La investigación de la compañía estima que incluso en situaciones diseñadas para evitar que ocurra, los chatbots inventan información al menos el 3 por ciento del tiempo — y hasta el 27 por ciento.

Los expertos llaman a este comportamiento de chatbot “ alucinación. ” Puede que no sea un problema para las personas que juegan con chatbots en sus computadoras personales, pero es un problema grave para cualquiera que use esta tecnología con documentos judiciales, información médica o datos comerciales confidenciales.

Debido a que estos chatbots pueden responder a casi cualquier solicitud de un número ilimitado de maneras, no hay forma de determinar definitivamente con qué frecuencia alucinan. “Tendrías que mirar toda la información del mundo,” dijo Simon Hughes, el investigador de Vectara que dirigió el proyecto.

Dr. Hughes y su equipo pidieron a estos sistemas que realizaran una tarea única y directa que se verifica fácilmente: Resumir artículos de noticias. Incluso entonces, los chatbots inventaron persistentemente la información.

“Le dimos al sistema de 10 a 20 hechos y le pedimos un resumen de esos hechos,” dijo Amr Awadallah, director ejecutivo de Vectara y ex ejecutivo de Google. “Que el sistema aún pueda introducir errores es un problema fundamental.”

Los investigadores argumentan que cuando estos chatbots realizan otras tareas — más allá del mero resumen — las tasas de alucinación pueden ser más altas.

Su investigación también mostró que las tasas de alucinaciones varían ampliamente entre las principales compañías de AI. Las tecnologías de OpenAIais tenían la tasa más baja, alrededor del 3 por ciento. Los sistemas de Meta, propietaria de Facebook e Instagram, rondaban el 5 por ciento. El sistema Claude 2 ofrecido por Anthropic, un rival de OpenAI también con sede en San Francisco, superó el 8 por ciento. Un sistema de Google, Palm chat, tuvo la tasa más alta con un 27 por ciento.

Una portavoz de Anthropic, Sally Aldous, dijo, “Hacer que nuestros sistemas sean útiles, honestos e inofensivos, lo que incluye evitar alucinaciones, es uno de nuestros objetivos principales como empresa

Google declinó hacer comentarios, y OpenAI y Meta no respondieron de inmediato a las solicitudes de comentarios.

Con esta investigación, el Dr. Hughes y el Sr. Awadallah quieren mostrar a la gente que deben desconfiar de la información que proviene de los chatbots e incluso del servicio que Vectara vende a las empresas. Muchas empresas ahora ofrecen este tipo de tecnología para uso comercial.

Con sede en Palo Alto, California, Vectara es una start-up de 30 personas respaldada por $28.5 millones en fondos iniciales. Uno de sus fundadores, Amin Ahmad, ex investigador de inteligencia artificial de Google, ha estado trabajando con este tipo de tecnología desde 2017, cuando se incubó dentro de Google y un puñado de otras empresas.

Editors’ Picks

Somewhat Guiltily, Ukrainians Miss Matthew Perry

The Youngest Senior

Have Art Auctions Become ‘Must-See TV’?

Al igual que el chatbot de búsqueda Bing de Microsoft puede recuperar información de Internet abierto, el servicio Vectaraars puede recuperar información de una colección privada de correos electrónicos, documentos y otros archivos de la empresa.

Los investigadores también esperan que sus métodos — que están compartiendo públicamente y continuarán actualizando — ayuden a estimular los esfuerzos en toda la industria para reducir las alucinaciones. OpenAI, Google y otros están trabajando para minimizar el problema a través de una variedad de técnicas, aunque no está claro si pueden eliminar el problema.

“Una buena analogía es un automóvil autónomo,” dijo Philippe Laban, investigador de Salesforce que ha explorado durante mucho tiempo este tipo de tecnología. “No puedes evitar que un automóvil autónomo se estrelle. Pero puede tratar de asegurarse de que sea más seguro que un conductor humano.”

Los chatbots como ChatGPT son impulsados por una tecnología llamada a modelo de lenguaje grande, ó L.L.M., que aprende sus habilidades analizando enormes cantidades de texto digital, incluidos libros, artículos de Wikipedia y registros de chat en línea. Al identificar patrones en todos esos datos, un L.L.M. aprende a hacer una cosa en particular: adivina la siguiente palabra en una secuencia de palabras.

Debido a que Internet está lleno de información falsa, estos sistemas repiten las mismas falsedades. También se basan en probabilidades: ¿Cuál es la posibilidad matemática de que la siguiente palabra sea “playwright”? De vez en cuando, adivinan incorrectamente.

La nueva investigación de Vectara muestra cómo puede suceder esto. Al resumir los artículos de noticias, los chatbots no repiten falsedades de otras partes de Internet. Simplemente se equivocan en el resumen.

Por ejemplo, los investigadores pidieron al modelo de lenguaje grande de Google, Palm chat, que resumiera este breve pasaje de un artículo de noticias:

Las plantas fueron encontradas durante la búsqueda de un almacén cerca de Ashbourne el sábado por la mañana. La policía dijo que estaban en “una casa de cultivo elaborada.” Un hombre de unos 40 años fue arrestado en la escena.

Dio este resumen, inventando completamente un valor para las plantas que el hombre estaba cultivando y asumiendo — quizás incorrectamente — que eran plantas de cannabis:

La policía arrestó a un hombre de unos 40 años después de que se encontraron plantas de cannabis por un valor estimado de £100,000 en un almacén cerca de Ashbourne.

Este fenómeno también muestra por qué una herramienta como el chatbot Bing de Microsoft puede equivocarse al recuperar información de Internet. Si le hace una pregunta al chatbot, puede llamar al motor de búsqueda Microsoft Microsoft Bing y ejecutar una búsqueda en Internet. Pero no tiene forma de identificar la respuesta correcta. Agarra los resultados de esa búsqueda en Internet y los resume para usted.

A veces, este resumen es muy defectuoso. Algunos bots citarán direcciones de Internet que están completamente inventadas.

Empresas como OpenAI, Google y Microsoft han desarrollado formas de mejorar la precisión de sus tecnologías. OpenAI, por ejemplo, trata de refinar su tecnología con comentarios de probadores humanos, que califican las respuestas de los chatbots, separando respuestas útiles y veraces de aquellas que no lo son. Luego, utilizando una técnica llamada aprendizaje de refuerzo, el sistema pasa semanas analizando las calificaciones para comprender mejor qué es un hecho y qué es ficción.

Pero los investigadores advierten que la alucinación del chatbot no es un problema fácil de resolver. Debido a que los chatbots aprenden de los patrones en los datos y operan de acuerdo con las probabilidades, se comportan de manera no deseada al menos algunas veces.

Para determinar con qué frecuencia los chatbots alucinaban al resumir artículos de noticias, los investigadores de Vectara usaron otro modelo de lenguaje grande para verificar la precisión de cada resumen. Esa era la única forma de verificar eficientemente una cantidad tan grande de resúmenes.

Pero James Zou, profesor de informática de Stanford, dijo que este método vino con una advertencia. El modelo de idioma que realiza la verificación también puede cometer errores.

“ El detector de alucinaciones podría ser engañado — o alucinarse a sí mismo, ” dijo.