IA

“Las personas con mucho menos poder y posiciones más marginadas estaban asumiendo riesgos personales reales para mencionar los problemas con la IA y las corporaciones que controlan la IA”

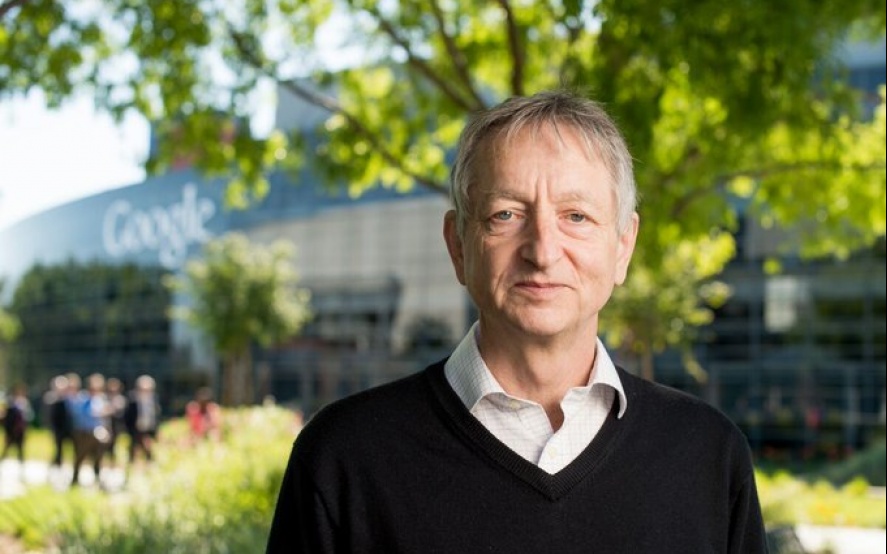

Lo han llamado el padrino de la inteligencia artificial, Geoffrey Hinton, dice que se va de Google y lamenta el trabajo de su vida.

Es difícil no preocuparse cuando el llamado padrino de la inteligencia artificial, Geoffrey Hinton, dice que deja Google y lamenta el trabajo de su vida.

Hinton, quien hizo una contribución fundamental a la investigación de la IA en la década de 1970 con su trabajo sobre redes neuronales, dijo a varios medios de comunicación esta semana que las grandes empresas de tecnología se estaban moviendo demasiado rápido en la implementación de la IA al público. Parte del problema era que la IA estaba logrando capacidades similares a las humanas más rápido de lo que habían pronosticado los expertos. “Eso da miedo”, le dijo al New York Times.

Las preocupaciones de Hinton ciertamente tienen sentido, pero habrían sido más efectivas si hubieran llegado varios años antes, cuando otros investigadores que no tenían jubilación a la que recurrir estaban haciendo sonar las mismas alarmas.

De manera reveladora, Hinton en un tweet buscó aclarar cómo el New York Times caracterizó sus motivaciones, preocupado porque el artículo sugería que había dejado Google para criticarlo. “En realidad, me fui para poder hablar sobre los peligros de la IA sin considerar cómo afecta esto a Google”, dijo. “Google ha actuado de manera muy responsable”.

Si bien la prominencia de Hinton en el campo podría haberlo aislado del retroceso, el episodio destaca un problema crónico en la investigación de IA: las grandes empresas de tecnología tienen un control tan absoluto sobre la investigación de IA que muchos de sus científicos temen expresar sus preocupaciones por temor a dañar su carrera. perspectivas

Puedes entender por qué. Meredith Whittaker, exdirectora de investigación de Google, tuvo que gastar miles de dólares en abogados en 2018 después de que ayudó a organizar la huelga de 20.000 empleados de Google por los contratos de la empresa con el Departamento de Defensa de EE. UU. “Da mucho, mucho miedo enfrentarse a Google”, me dice. Whittaker, quien ahora es director ejecutivo de la aplicación de mensajería encriptada Signal, finalmente renunció al gigante de las búsquedas con una advertencia pública sobre la dirección de la empresa.

Dos años más tarde, los investigadores de IA de Google, Timnit Gebru y Margaret Mitchell, fueron despedidos del gigante tecnológico después de publicar un artículo de investigación que destacaba los riesgos de los grandes modelos de lenguaje, la tecnología que actualmente está en el centro de las preocupaciones sobre los chatbots y la IA generativa. Señalaron cuestiones como los prejuicios raciales y de género, la inescrutabilidad y el costo ambiental.

Whittaker se irrita por el hecho de que Hinton ahora es objeto de retratos brillantes sobre sus contribuciones a la IA después de que otros asumieron riesgos mucho mayores para defender lo que creían mientras aún trabajaban en Google. “Las personas con mucho menos poder y posiciones más marginadas estaban asumiendo riesgos personales reales para nombrar los problemas con la IA y las corporaciones que controlan la IA”, dice.

¿Por qué Hinton no habló antes? El científico se negó a responder a las preguntas. Pero parece haber estado preocupado por la IA durante algún tiempo, incluso en los años en que sus colegas se agitaban por un enfoque más cauteloso de la tecnología. Un artículo del New Yorker de 2015 lo describe hablando con otro investigador de IA en una conferencia sobre cómo los políticos podrían usar la IA para aterrorizar a la gente. Cuando se le preguntó por qué seguía investigando, Hinton respondió: "Podría darte los argumentos habituales, pero la verdad es que la perspectiva del descubrimiento es demasiado dulce". Fue un eco deliberado de la famosa descripción de J. Robert Oppenheimer del atractivo "técnicamente dulce" de trabajar en la bomba atómica.

Hinton dice que Google ha actuado “muy responsablemente” en su despliegue de IA. Pero eso es solo parcialmente cierto. Sí, la compañía cerró su negocio de reconocimiento facial por preocupaciones de uso indebido, y mantuvo en secreto su poderoso modelo de lenguaje LaMDA durante dos años para trabajar para hacerlo más seguro y menos sesgado. 1 Google también ha restringido las capacidades de Bard, su competidor a ChatGPT.

Pero ser responsable también significa ser transparente y rendir cuentas, y el historial de Google de sofocar las preocupaciones internas sobre su tecnología no inspira confianza.

Se espera que la partida y las advertencias de Hinton inspiren a otros investigadores de grandes empresas tecnológicas a hablar sobre sus preocupaciones.

Los conglomerados tecnológicos se han tragado algunas de las mentes más brillantes del mundo académico gracias al atractivo de los altos salarios, los generosos beneficios y la enorme potencia informática utilizada para entrenar y experimentar con modelos de IA cada vez más potentes.

Sin embargo, hay señales de que algunos investigadores al menos están considerando ser más expresivos. “A menudo pienso en cuándo dejaría [la puesta en marcha de IA] Anthropic o dejaría AI por completo”, tuiteó Catherine Olsson, miembro del personal técnico de la empresa de seguridad de IA Anthropic el lunes, en respuesta a los comentarios de Hinton. “Ya puedo decir que este movimiento me influirá”.

Muchos investigadores de IA parecen tener una aceptación fatalista de que poco se puede hacer para detener la ola de IA generativa, ahora que se ha desatado en el mundo. Como me dijo el cofundador de Anthropic, Jared Kaplan, en una entrevista publicada el martes, "el gato está fuera de la bolsa".

Pero si los investigadores de hoy están dispuestos a hablar ahora, mientras importa, y no justo antes de jubilarse, es probable que todos nos beneficiemos.

#HASHTAGS